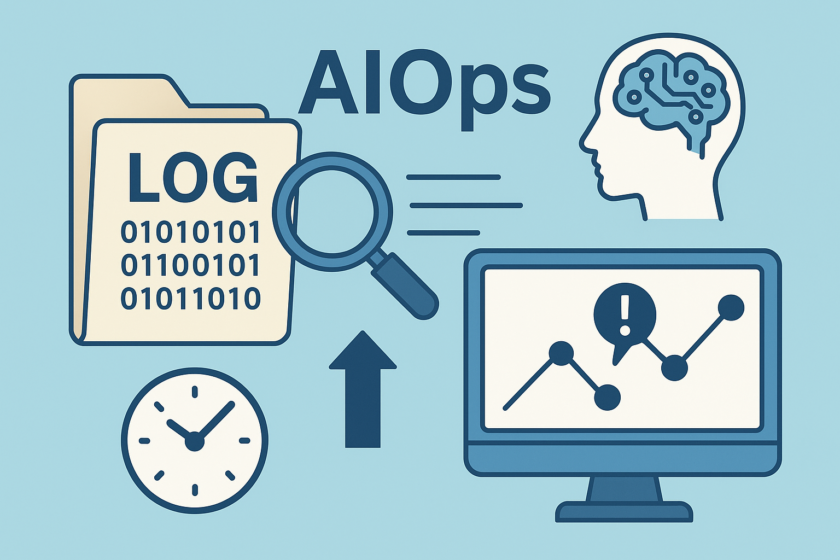

AI-Driven AIOps Architecture: How to Search 1TB Logs Instantly and Make Incident Detection 5x Faster

Contents

AIOpsでログ1TBを即検索し、障害検知を5倍速にするという現実的なゴール

開発組織の改善担当として日々向き合うのは、「感覚的な改善」ではなく、MTTR・障害検知までの時間・一次切り分け工数のような数字をどう縮めるか、という現実的な問いだと思います。サービス規模が大きくなるほどログは雪だるま式に増え、1日あたり1TB規模のログ分析が必要になるケースも珍しくありません。このボリュームで従来型のログ分析だけに頼ると、検索クエリ1本に数十秒〜数分かかり、肝心の障害検知と原因追跡は「人力根性勝負」になりがちです。ここで注目されるのが、AIを活用したAIOpsです。AIOpsプラットフォームをうまく設計・導入すると、ログ分析・メトリクス・トレースを横断しながら、障害検知を機械的に高速化し、1TB規模のデータに対しても「ほぼ即検索」に近い体験をエンジニアに提供できます。

ただし、AIOpsは「入れれば勝手に賢くなる魔法の箱」ではありません。適切なログ分析基盤がないままAIOpsを導入すると、ノイズだらけのアラートが乱発され、むしろ障害検知が遅くなったり、現場がAIOps運用から離反したりします。本記事では、AIOpsを前提にログ分析の設計を見直し、1TB規模でもストレスなく検索できるアーキテクチャを構築しつつ、障害検知を5倍速に近づける具体的なステップを解説します。単なる概念やツール名の紹介ではなく、「どのようなログ分析を整え、どのようなAIOps運用プロセスを設計すると、実際に数字が変わるのか」を、現場目線で掘り下げます。読み終えたときに、自社の環境にAIOpsをどう合わせ込むかをイメージできる状態を目指しています。

AIOpsを活かす前提条件:ログ分析の標準化と運用設計が9割を決める

AIOpsを導入する前に必ず押さえたいのが、「データと運用設計が整っていなければ、どんなAIOpsも成果を出せない」という点です。まず、ログ分析に耐えうるログ構造を揃える必要があります。サービスごとにバラバラなログフォーマットや、タイムスタンプや環境情報が欠けているログが混在していると、どれだけ高度なAIOpsプラットフォームを導入しても、精度の高い障害検知は実現できません。最低限として、サービス名・環境(本番/ステージングなど)・トレースIDやリクエストID・ユーザーID・バージョン・ログレベルなどを、すべてのログに一貫して含めることが、ログ分析とAIOps運用の土台になります。

次に重要なのが、何をもって成功とみなすかを、事前に数値指標として定義することです。たとえば、「障害検知までの平均時間を半分にする」「一次切り分け完了までの時間を3分の1にする」「オンコール1回あたりのログ分析作業を30%削減する」といったKPIを設定し、AIOps導入前後で比較できる状態を作ります。こうしたKPIは、ログ分析や監視ツールのメトリクスからダッシュボード化しておくと、AIOpsの効果が可視化され、経営層や他部署に説明しやすくなります。逆に、この観点を欠いたままAIOpsを導入すると、「ツールは入れたけれど障害検知が楽になったのか分からない」というモヤモヤだけが残ります。

また、AIOps運用における人と機械の役割分担も事前に決めておく必要があります。AIOpsに任せるのは、「どのログ分析結果をアラートに昇格させるか」「どの障害検知パターンに既存Runbookを自動で紐づけるか」といった自動化しやすい部分です。一方で、ビジネス影響度の判断やコミュニケーションなどは、今後も人が担う領域です。この境界線が曖昧だと、AIOpsが出した障害検知結果を誰も信用せず、結局は従来のログ分析に戻ってしまいます。AIOps導入時には、「AIOps運用で自動化する範囲」と「SRE・開発・CSが担う判断」を文章化しておくことが、安定した障害検知と継続的なログ分析改善につながります。

3分でできる! 開発費用のカンタン概算見積もりはこちら

ログ1TBを即検索に近づけるAIOps対応アーキテクチャ

1日1TB規模のログ分析を前提とするなら、アーキテクチャ設計の段階からAIOpsと障害検知を意識する必要があります。よくある失敗は、「とりあえずフルマネージドなログ分析基盤に全部流し込み、あとはAIOpsプラットフォーム側で何とかする」というパターンです。この方式では、保存コストが膨らむだけでなく、インデックスが肥大化して検索や障害検知の速度が落ち、AIOps運用の肝である「リアルタイム性」が失われます。そこで有効なのが、ストリーム処理で収集したログを、ホットストアとコールドストアに分割する二層構造です。ホットストアには直近数日〜数週間分のログを格納し、AIOpsによるリアルタイムなログ分析・障害検知・相関分析に利用します。コールドストアには長期保管分を圧縮して保存し、法的要件や後追い調査に必要な際のみバッチ的に参照します。

このアーキテクチャを支える鍵は、パーティション設計とカーディナリティの制御です。ログ分析基盤において、ラベルやタグの種類を無計画に増やしてしまうと、インデックスサイズが爆発し、AIOpsの障害検知アルゴリズムが処理しきれなくなります。「サービス名」「環境」「リージョン」といった軸でパーティションを切りつつ、ユーザーIDやセッションIDなど高カーディナリティの情報は、必要に応じてサマリーテーブルに落とすなどの工夫が必要です。また、AIOpsが機能するためには、ログ分析基盤の取り込みレイテンシも重要です。ログがストリームからホットストアに反映されるまでの遅延が数分以上あると、障害検知が本番に役立たないため、収集エージェントやバッファの設計段階で「どこまで遅延を許容するか」を詰めておくべきです。

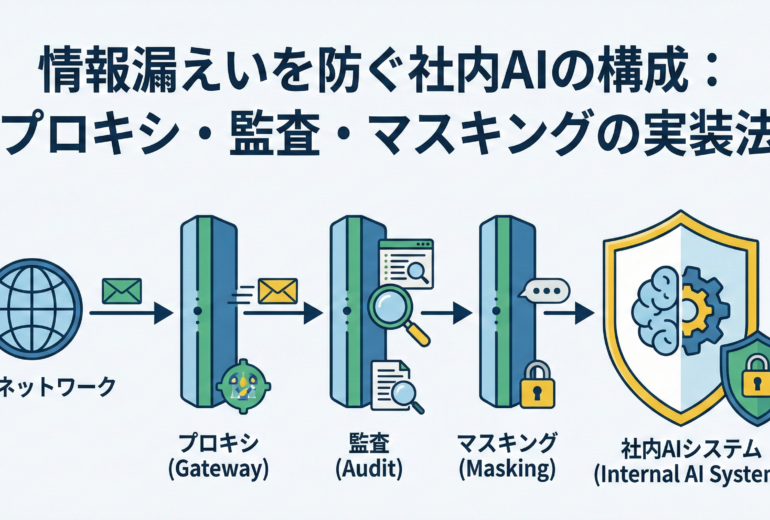

さらに、アーキテクチャ設計段階でアクセス制御とセキュリティも組み込んでおかないと、後からAIOpsのカバレッジを広げるときに躓きます。たとえば、本番ログを扱うAIOpsプラットフォームに対しては、RBACによる権限管理、個人情報を含むログのマスキング、監査ログの保存といった要件がついて回ります。ここをログ分析基盤と一体で設計しておくことで、法令順守や監査対応を気にせず、障害検知やAIOps運用の拡大を進めやすくなります。技術要素だけでなく、「どの部署がどのログにアクセスできるべきか」という組織設計まで含めてアーキテクチャを描くことが、1TB時代のログ分析とAIOps導入を成功に導きます。

障害検知を5倍速にするAIOpsパイプラインと運用フロー

障害検知を「5倍速」に近づけるためには、AIOpsを中心にしたインシデントライフサイクル全体の再設計が欠かせません。最初のステップは、ログ分析とメトリクスから得られるシグナルを統合し、AIOpsプラットフォーム上で「障害候補イベント」として扱う層を作ることです。この層では、単純な閾値アラートだけでなく、統計的な異常検知やパターンマイニングを用いて、ログ分析上の急激なエラー増加やレスポンス遅延を自動検出します。そのうえで、同時刻帯に発生したエラーやイベントをAIOpsがクラスタリングし、「1つの障害」としてグルーピングすることで、ノイズを減らしつつ障害検知の見通しを良くします。

次に、AIOpsによってグルーピングされたインシデント候補に対し、自動の一次切り分けを行います。ここでは、ログ分析の結果をもとに、「直近でデプロイされたサービス」「関連する依存サービス」「発生している環境やリージョン」といった情報をAIOpsが整理し、障害検知から数十秒以内にエンジニアに提示します。最近は、ここにLLMを組み合わせ、「この障害は過去のどの事例に似ているか」「どのRunbookを参照すべきか」などを自然言語でサジェストするAIOps運用も増えています。これにより、エンジニアはゼロからログ分析を始めるのではなく、AIOpsがまとめた仮説から検証をスタートでき、結果として障害検知後の初動時間が大きく短縮されます。

もちろん、LLMを用いたAIOpsには誤検知や誤った推測というリスクもあります。そのため、アラートの精度を継続的に改善するフィードバックループが重要になります。インシデント対応後には、「どのログ分析クエリが決め手になったか」「どの障害検知ルールが機能したか」「不要なアラートは何だったか」を振り返り、AIOpsのルールやモデルに反映させます。これを月次や四半期単位で続けることで、AIOps運用は徐々に現場にフィットし、ログ分析の負担を減らしながら障害検知のスピードと精度を同時に高めていきます。重要なのは、「AIOpsがすべてを判断する」のではなく、「AIOpsがログ分析と障害検知を加速し、人が最終判断を下す」役割分担を明確にすることです。

3分でできる! 開発費用のカンタン概算見積もりはこちら

90日でAIOpsとログ分析を定着させる導入ステップと体制づくり

AIOps導入がPoC止まりになりがちな理由の一つは、スコープと期限が曖昧なまま進めてしまうことです。そこで、約90日を目安とした具体的な導入ステップを設定することをおすすめします。最初の30日では、対象となるサービスを1〜2つに絞り込み、そのサービスに関わるログ分析基盤の整備と可視化に集中します。この段階では、AIOpsプラットフォームの機能をすべて使い切る必要はなく、「障害検知に関係するログが漏れなくホットストアに入り、すぐに検索できる状態か」を確認することがゴールです。合わせて、現状のMTTRや障害検知時間などのベースラインをダッシュボード化し、AIOps導入前の「現在地」を共有します。

次の30日では、インシデント対応プロセスとRunbookの整備にフォーカスします。過去3〜6か月分の障害を棚卸しし、それぞれについて「どのログ分析が有効だったか」「どの時点で障害検知できていればもっと早く対応できたか」を振り返ります。その結果をもとに、AIOps上で再利用可能な障害検知ルールや自動アクションを定義し、Runbookをひな形として登録します。このフェーズで重要なのは、SRE・開発・CSなど関係者を巻き込み、「AIOpsが出した障害検知結果を誰がどの順番で扱うのか」という運用フローを具体的に決めておくことです。

最後の30日では、体制とガバナンスの強化に取り組みます。AIOps運用における役割分担(ルール設計担当、ログ分析基盤の保守担当、インシデントレビューのファシリテーターなど)を明確にし、月次でのレビュー会や改善サイクルを定例化します。また、ログ分析とAIOpsに多くの個人情報やシステム内部情報が含まれることを踏まえ、アクセス権限・監査ログ・セキュリティ方針も見直す必要があります。この90日間を通じて、「AIOpsを導入したので便利になったはず」という曖昧な状態ではなく、「障害検知がこれだけ速くなり、ログ分析工数がこれだけ削減された」という数字での説明が可能になります。そのうえで、より大きなサービス群へのAIOps展開や、より高度なログ分析・自動化へとステップアップしていくのが理想的な流れです。

まとめ:AIOpsで「数字で説明できる運用改善」を実現する

本記事では、1TB規模のログ分析を前提としたAIOpsの導入と、障害検知を5倍速に近づけるための実践的な構成・運用を整理しました。鍵になるのは、まずログ分析の標準化とKPI設計を先に行い、その上でAIOpsを使った自動障害検知・一次切り分け・Runbook連携を設計することです。ログ分析基盤のアーキテクチャをホットストア/コールドストアの二層構造にし、パーティション設計やカーディナリティ制御を意識することで、1日1TB規模でも「即検索」に近いレスポンスを実現しやすくなります。また、AIOpsを「何でも判断してくれるAI」と捉えるのではなく、「ログ分析と障害検知を加速する強力なアシスタント」と位置付け、人間が最終判断を行う運用設計にすることが、現場の信頼を得るうえで不可欠です。

実務的には、90日程度の導入ロードマップを設定し、範囲を絞ったPoCから始めて徐々に対象と自動化の範囲を広げていくことが現実的です。その過程で、「どのログ分析が価値を生んでいるか」「どの障害検知ルールがノイズになっているか」を定期的に振り返り、AIOpsと運用プロセスを一緒に育てていく姿勢が求められます。もし「AIOpsに興味はあるが、自社のログ分析基盤や障害検知フローをどう整理すればよいか分からない」「どこまでを自前で作り、どこから外部に頼るべきか判断が難しい」と感じている場合は、外部パートナーと一度、現状とゴールを一緒に棚卸ししてみるのも良い選択肢です。

お問い合わせ・無料相談はこちら

「このAIOps構成は自社に当てはまるのか知りたい」「ログ1TB規模のログ分析コストと障害検知スピードのバランスを相談したい」

「既存の監視運用をAIOps前提で再設計したい」といったご相談に対して、現状ヒアリングから指標設計、構成案の叩き台、段階的な導入ステップの整理まで伴走します。

社内説明にそのまま使える検討メモや構成比較資料の形にまとめることも可能です。

AIOpsとログ分析のテーマは、ツール名やバズワードだけを追っても前に進みません。本当に重要なのは、「障害検知が何分早くなったか」「オンコール1回あたりの負荷がどれだけ軽くなったか」といった数字で語れる改善です。そうした「数字で説明できる運用改善」を目指すパートナーとして、株式会社ソフィエイトは、AIOpsの構想段階から具体的なログ分析設計・実装・運用定着まで、一貫してご支援できます。

株式会社ソフィエイトのサービス内容

- システム開発(System Development):スマートフォンアプリ・Webシステム・AIソリューションの受託開発と運用対応

- コンサルティング(Consulting):業務・ITコンサルからプロンプト設計、導入フロー構築を伴走支援

- UI/UX・デザイン:アプリ・Webのユーザー体験設計、UI改善により操作性・業務効率を向上

- 大学発ベンチャーの強み:筑波大学との共同研究実績やAI活用による業務改善プロジェクトに強い

コメント